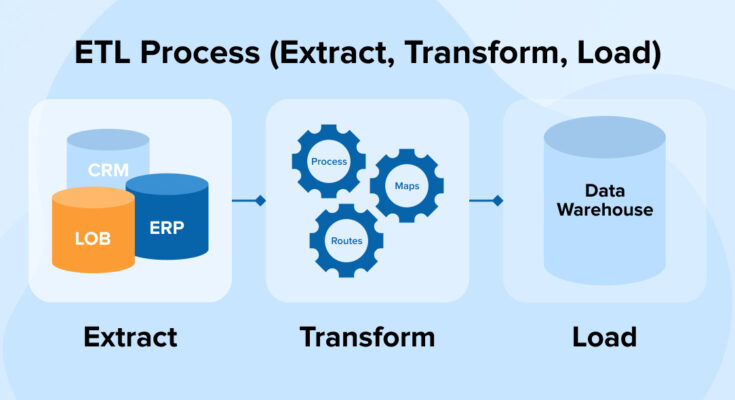

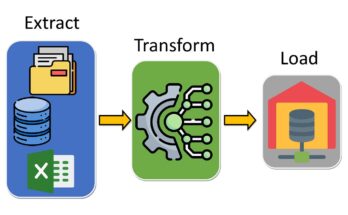

O ETL (Extract, Transform, Load) é um processo fundamental para transformar dados brutos em informações úteis. Para quem está começando, entender como ele funciona e por que é importante é o primeiro passo para trabalhar com dados em grandes volumes. Vamos explicar cada etapa do ETL, com exemplos práticos e algumas dicas.

🧠 O que é ETL?

ETL é um processo de extração, transformação e carregamento de dados. Ele é usado para:

- Extrair dados de fontes diversas (ex: bancos de dados, APIs, arquivos).

- Transformar os dados para garantir qualidade, padronização e compatibilidade.

- Carregar os dados em um destino (ex: data warehouse, data lake).

Por que é importante?

- Permite que empresas tomem decisões baseadas em dados precisos.

- Facilita a integração de sistemas heterogêneos.

- Melhora a eficiência de relatórios e análises.

📡 Etapa 1: Extração (Extract)

O que é?

Coletar dados de fontes diferentes, como bancos de dados, APIs, arquivos CSV ou sistemas de terceiros.

Exemplo Prático

Imagine que uma empresa quer analisar vendas de um e-commerce.

- Fontes:

- Banco de dados MySQL com clientes.

- Arquivos CSV com transações.

- API do Google Analytics para métricas de tráfego.

Ferramentas

- Extractors: Talend, Python (pandas).

- Banco de dados: MySQL, PostgreSQL, Oracle.

- Arquivos: S3, Azure Blob Storage, Google Cloud Storage.

Dica para iniciantes:

Comece com dados em formatos simples, como CSV, para evitar complicações.

🧹 Etapa 2: Transformação (Transform)

O que é?

Limpar, unir, calcular e formatar os dados para torná-los úteis.

Exemplo Prático

Continuando o exemplo do e-commerce:

- Limpeza: Remover registros duplicados ou inválidos.

- Padronização: Converter datas para o formato (YYYY-MM-DD).

- Cálculos: Calcular o total de vendas por região.

- Unir dados: Juntar informações de clientes com transações.

Ferramentas

- Apache Spark: Processamento em larga escala.

- SQL: Consultas para transformação.

- Delta Lake: Gestão de versão de dados.

Dica para iniciantes:

Use scripts simples no Python ou SQL para começar.

📦 Etapa 3: Carregamento (Load)

O que é?

Armazenar os dados transformados em um destino, como um data warehouse ou data lake.

Exemplo Prático

- Destino: Um data warehouse no Redshift para relatórios.

- Formato: Armazenar dados em tabelas relacionais.

- Automatização: Usar pipelines para carregar dados a cada hora ou dia.

Ferramentas

- Data Warehouses: Redshift, Snowflake, BigQuery.

- Data Lakes: S3, Azure Data Lake.

- Ferramentas de Pipeline: Apache Airflow, Databricks.

Dica para iniciantes:

Comece com carregamento manual para entender o processo.

🛠️ Exemplo Completo: ETL em uma Empresa de Varejo

Cenário

Uma empresa quer analisar vendas de diferentes lojas.

Passos do ETL

- Extração:

- Coletar dados de vendas (CSV) e estoque (MySQL).

- Transformação:

- Limpar dados com valores nulos.

- Calcular o total de vendas por loja.

- Carregamento:

- Armazenar resultados no Redshift para relatórios.

Resultado:

- Relatórios mensais com insights sobre desempenho das lojas.

⚠️ Desafios para Iniciantes

- Diversidade de Fontes:

- Dados podem estar em formatos diferentes (CSV, JSON, SQL).

- Qualidade dos Dados:

- Lidar com valores faltantes ou inconsistentes.

- Escalabilidade:

- Processar grandes volumes de dados sem lentidão.

Solução:

- Use ferramentas como Apache Spark para escalabilidade.

- Validar dados antes da transformação.

📊 Ferramentas para Iniciantes

| Etapa | Ferramenta | Descrição |

|---|---|---|

| Extração | Python (pandas) | Coletar dados de arquivos simples |

| Transformação | SQL/Spark | Processar dados com consultas |

| Carregamento | Redshift/Snowflake | Armazenar em data warehouse |

✅ Conclusão

O ETL é a base para qualquer projeto de análise de dados. Utilizando ferramentas como Python, SQL e Apache Spark, é possível transformar dados brutos em informações valiosas.